随着chatGPT的爆火和AGI的繁荣,英伟达正在以前所未见的速度发展,这不但造就了GPU的繁荣,同时还让扮演关键角色HBM热度高居不下。

继美光和SK Hynix在日前表示,今年的HBM产能自己售罄以后。美光和三星在近日也带来了HBM新品,以期在这个蓬勃发展的市场占有一席之地。其中,前者带来了将用在英伟达GH200的之余,还表示将在2024 年 3 月带来36 GB 12-Hi HBM3E 产品,后者则表示,公司发布的HBM3E 12H将性能和容量提高了 50% 以上。

由此可见,HBM的竞争愈演愈烈,HBM也成为了决定AI芯片命运的关键。这也就是为何Timothy Prickett Morgan认为,谁掌控了HBM,就掌握了AI训练。

以下为Timothy Prickett Morgan的分享正文:

2024 年推动 Nvidia 数据中心 GPU 加速器发展的最重要因素是什么?

是即将推出的“Blackwell”B100 架构吗?我们确信该架构将比当前的“Hopper”H100 及其胖内存弟弟 H200 提供性能飞跃?不。

是该公司有能力从代工合作伙伴台积电那里拿回数百万颗 H100 和 B100 GPU 芯片吗?不,它不是。

是Nvidia AI Enterprise 软件堆栈及其 CUDA 编程模型和数百个库吗?事实上,至少其中一些软件(如果不是全部)是 AI 训练和推理的事实上的标准。不过,又没有。

虽然所有这些无疑都是巨大的优势,并且是许多竞争对手都集中精力的优势,但 Nvidia 在 2024 年推动其业务的最重要因素与金钱有关。具体来说:英伟达在 1 月份结束了 2024 财年,现金和银行投资略低于 260 亿美元,如果本财年按预期进行,收入将突破 1000 亿美元,其中约占 50% 以上如果以净利润的形式体现出来,那么即使在支付了税款、庞大的研发业务以及公司的正常运营费用之后,它将为其金库增加约 500 亿美元。

你可以用 750 亿美元或更多的资金做很多事情,其中之一就是不必太担心为数据中心级 GPU 购买 HBM 堆栈 DRAM 内存所需的巨额资金。这种内存正在以相当好的速度变得更快、更密集(就每芯片千兆位而言)和更胖(FAT,就兆字节带宽和千兆字节容量而言),但其改进速度并没有达到人工智能加速器所需的速度。

随着美光科技 (Micron Technology) 加入 SK 海力士 (SK Hynix) 和三星 (Samsung) 的供应商行列,HBM 的供应量有所改善,并且进给量和速度也随之改善。我们强烈怀疑供应将无法满足需求,HBM 内存的价格将随着 HBM 在一定程度上推动的 GPU 加速器价格而继续攀升。

AMD 拥有 57.8 亿美元的现金和投资,没有那么多闲置资金,尽管英特尔的银行存款略高于 250 亿美元,但它必须建立代工厂,这确实非常昂贵(按顺序如今每次流行 150 亿至 200 亿美元)。因此,它也确实不能在 HBM 内存上挥霍。

对 Nvidia GPU 加速器业务有利的另一个因素是,在 GenAI 繁荣时期,客户愿意为数百、数千甚至数万个数据中心 GPU 支付几乎任何费用。我们认为,2022 年 3 月宣布的原始“Hopper”H100 GPU的价格,特别是在 SXM 配置中,对于具有 80 GB HBM3 内存、速度为 3.35 TB/秒的单个 H100,其价格超过 30,000 美元,我们不知道具有 96 GB 内存,速度为 3.9 TB/秒的H100的费用,但我们能推测 Nvidia 对具有 141 GB HBM3E 内存、运行速度为 4.8 TB/秒的 H200 设备的收费。H200 基于与 H100 完全相同的“Hopper”GPU,将内存容量提高了 76.3%,内存带宽提高了 43.3%,H100 芯片的性能提高了 1.6 倍到 1.9 倍。考虑到额外的容量意味着需要更少的 GPU 并消耗更少的电量来针对静态数据集训练给定模型,我们认为与原始 H100 相比,Nvidia 可以轻松地为 H200 收取 1.6 倍到 1.9 倍的费用。

黄金法则:拥有黄金的人制定规则

我们并不是说 H200 在第二季度开始发货时就会发生这种情况。(我们认为英伟达除了财务数据外还谈论日历季度。)我们只是说这样的举动是有逻辑的。很大程度上取决于 AMD 对“Antares” Instinct MI300X GPU 加速器的收费,该加速器具有 192 GB 的 HBM3,运行速度为 5.2 TB/秒。MI300X 具有更多的原始浮点和整数能力,HBM 容量比 Nvidia 的 H200 高 36.2%,带宽比 H200 高 10.4%。

你可以用 Elon Musk 的最后一块钱打赌,AMD 没有心情做任何事,除了对 MI300X 收取尽可能多的费用,甚至有建议称该公司正在努力升级到更胖、更快的 HBM3E内存领域,以保持对Nvidia的竞争。MI300 使用具有八高 DRAM 堆栈的 HBM3,MI300 中的内存控制器具有信号和带宽容量,可以替换为时钟速度更快的十二高堆栈HBM3E 。这意味着容量增加了 50%,带宽也可能增加了 25%。也就是说,每个 MI300X 具有 288 GB 的 HBM3E 容量和 6.5 TB/秒的带宽。

据推测,这样一个经过精心设计的 MI350X 芯片(我们可能会这样称呼它)在其峰值失败次数中执行了相当大的实际工作量,甚至更多,就像 Nvidia 从 H100 跳跃到 H200 时所发生的那样。

正是在这样的背景下,我们想谈谈 HBM 领域发生的事情。我们将从 SK Hynix 开始,该公司展示了 16 个芯片高的 HBM3E 堆栈,每个堆栈提供 48 GB 的容量和 1.25 TB/秒的带宽。MI300X 配备 8 个内存控制器,可实现 384 GB 内存和 9.6 TB/秒带宽。

有了这些数字,您就不必将 CPU 作为扩展内存控制器来处理大量工作负载。。。。

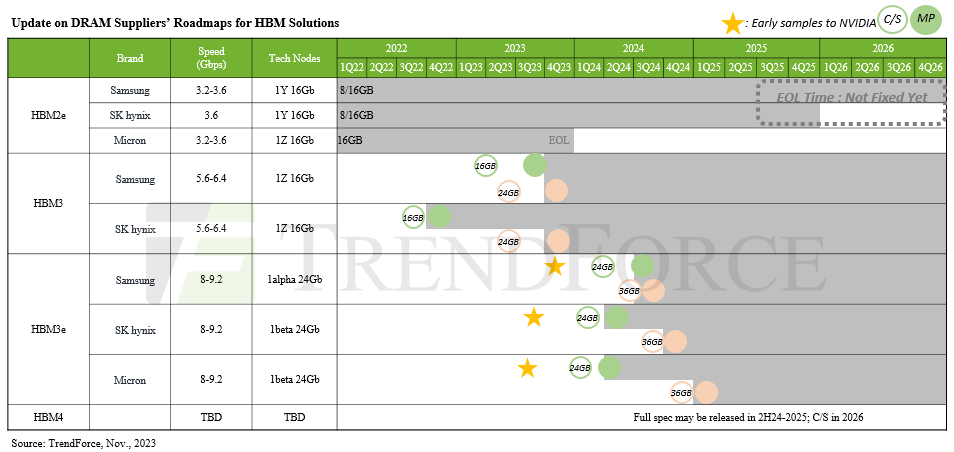

我们还没有看到关于SK海力士十六高HBM3E内存的介绍,也不知道它什么时候上市。去年 8 月,SK 海力士展示了第五代 HBM 内存和第一代 HBM3E 内存,据称每个堆栈可提供 1.15 TB/秒的带宽。正如下面由 Trendforce 创建的 HBM 路线图所示,我们的预期是提供 24 GB 和 36 GB 容量,这意味着 8 高堆栈和 12 高堆栈。

去年 8 月,Nvidia 显然将成为这些芯片的大客户,并且有传言称 SK Hynix 的这款 24 GB HBM3E 内存将用于即将推出的“Blackwell”B100 GPU 加速器。如果是这样,那么 Blackwell GPU 小芯片上的六个内存控制器将产生 144 GB 的容量,如果 B100 封装按预期具有两个 GPU 小芯片,则意味着最大容量为 288 GB,带宽为 13.8 TB/秒。很难说收益率如何,可能只有 5/6 可用。也有可能 - 但我们希望不是 - B100 看起来不像一个 GPU,而是系统软件的两个 GPU(就像两个芯片组 AMD“Arcturus”MI250X 所做的那样,而不像 MI300X 那样,后者有 8 个较小的 GPU 芯片组这加起来会带来更多的魅力,看起来就像一个 GPU 到系统软件)。我们将看看那里会发生什么。

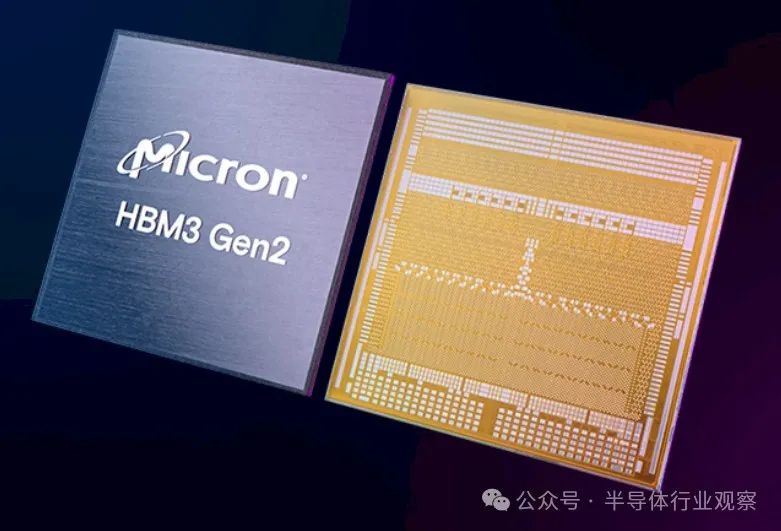

美光科技 (Micron Technology) 进入 HBM 领域较晚,但鉴于供应短缺和需求旺盛,该公司无疑在该领域最受欢迎,该公司今天表示,它正在开始生产其首款 HBM3E 内存,这是一种八高堆栈容量为 24 GB,并补充说该内存是 H200 GPU 的一部分。我们去年 7 月介绍过的Micron HBM3E 变体的引脚运行速度为 9.2 Gb/秒,每个堆栈提供 1.2 TB/秒的内存。美光还声称,其 HBM3E 内存的消耗量比“竞争产品”少 30%,想必它正在谈论严格的 HBM3E 比较。

美光还表示,它已开始对其 12 高 36 GB HBM3E 变体进行送样,其运行速度将超过 1.2 TB/秒。美光没有透露比 1.2 TB/秒快多少。

今天晚些时候,三星推出了十二高堆栈 HBM3E,这也是其第五代产品,该公司代号为“Shinebolt”。

Shinebolt 取代了去年推出的“Icebolt”HBM3 内存。Icebolt 堆栈式 DRAM 内存为容量为 24 GB 的十二层堆栈提供 819 GB/秒的带宽。Shinebolt HBM3E 在 36 GB 堆栈中提供 1.25 TB/秒的带宽,就像 SK Hynix HBM3E 十二高堆栈一样。

三星在公告中补充道:“用于AI应用时,预计与采用HBM3 8H相比,AI训练的平均速度可提高34%,同时推理服务的并发用户数可提升34%。”扩大11.5倍以上。” 三星指出,这是基于内部模拟,而不是实际的人工智能基准。

三星的 Shinebolt HBM3E 12H 现已提供样品,预计在 6 月底前全面投产。

这些 12 高和 16 高的 HBM3E 堆栈几乎是我们在 2026 年 HBM4 发布之前所拥有的。人们可能希望 HBM4 会在 2025 年出现,毫无疑问,我们面临着推动路线图升级的压力,但这似乎不太可能。据猜测,HBM4 的内存接口将增加一倍,达到 2,048 位。HBM1 到 HBM3E 使用了 1,024 位内存接口,信号传输速度从 AMD 与 SK Hynix 设计并于 2013 年交付的初始 HBM 内存相比,已经从 1 Gb/秒增加到 9.2 Gb/秒。接口加倍将允许两倍的速度。需要大量内存来挂起接口,并以一半的时钟速度提供给定量的带宽,并且随着时钟速度再次提升,带宽会逐渐增加。或者。它们从一开始就以每引脚 9.2 Gb/秒的速度推出,我们只需支付以瓦为单位的价格。

美光路线图表示,HBM4 将提供 36 GB 和 64 GB 的容量,驱动速度为 1.5 TB/秒到 2 TB/秒,因此看起来会是宽速和慢速、宽速和更快的混合,但在发布时不会完全满足需求。谈到带宽。看起来,宽度加倍几乎可以使容量和带宽加倍。预计 HBM4 将具有十六层 DRAM 堆叠,仅此而已。

在 2026 年另一个宇宙的梦想世界中,HBM4 将拥有 2,048 位接口,类似于引脚上的 11.6 Gb/秒信号传输,具有 24 个高 DRAM 堆叠,具有 33.3% 密度的 DRAM 内存(4 GB 而不是 3 GB),因此,每个堆栈的速度约为 3.15 TB/秒,每个堆栈的速度约为 96 GB。哦,那我们就疯狂吧。假设一个 GPU 复合体有十几个小芯片,每个小芯片都有自己的 HBM4 内存控制器。这将为每个 GPU 设备提供 37.8 TB/秒的聚合内存带宽,以及每个设备 1,152 GB 的容量。

从这个角度来看,根据 Nvidia 的说法,一个 1750 亿个参数的 GPT-3 模型需要 175 GB 的容量来进行推理,因此我们正在讨论的理论 GPU 上的内存大小大概能够处理 1.15 万亿个参数推理。对于 GPT-3 训练,需要 2.5 TB 内存来加载数据语料库。如果您的 Hoppers 具有 80 GB HBM3 内存,则需要 32 个 Hopper 才能完成这项工作。但我们的 32 台设备的容量将增加 14.4 倍,因此能够加载相应更大的数据量。我们假设的设备上的带宽也高出 11.3 倍。

请注意,我们没有提及这十几个 GPU 小芯片的失败情况?在大多数情况下,以超过 80% 的利用率运行任何东西都非常棘手,特别是当它可能以不同的精度执行不同的操作时。我们想要的是让触发器与比特/秒的比率恢复正常。我们想要制造一台 12 缸发动机,它有足够的喷油器来实际喂养野兽。

我们的猜测是,80 GB 的 H100 的 HBM3 内存约为理想值的三分之一,带宽也约为理想值的三分之一。这是一种最大化 GPU 芯片销售和收入的方法,正如 Nvidia 已经清楚地证明的那样,但这并不是构建平衡的计算引擎的方法 - 就像英特尔在其 X86 芯片上放置一半的 DRAM 内存控制器并将其全部卖给我们一样——两个带有中间仓部件的插座一直是数据中心通用计算的正确答案。我们还需要更多的内存容量和带宽。

因此,如果使用这个概念性 Beast GPU 加速器将带宽增加 11.3 倍,那么与原始 H100 相比,计算量可能只会增加 4 倍。在张量核心上,H100 在 FP64 精度下的额定速度为 67 teraflops,在 FP8 精度(未使用稀疏性)下的额定速度为 1.98 petaflops。因此,这个 TP100 GPU 复合体在 FP64 下的额定速度为 268 teraflops,在 FP8 下的额定速度为 7.92 petaflops,每个 GPU 小芯片的性能将是 H100 芯片性能的三分之一,并且可能是其大小的四分之一到五分之一,具体取决于使用的工艺技术。假设它是 TSMC 2N 或 Intel 14A 与真正的 H100 上使用的 TSMC 4N。毕竟,这是我们谈论的 2026 年。

这就是我们想要写的那种野兽,如果我们银行里有 260 亿美元,并且未来还有 500 亿美元以上的前景,这就是我们会做的。但是大量的 HBM 内存和计算引擎都塞满了它。

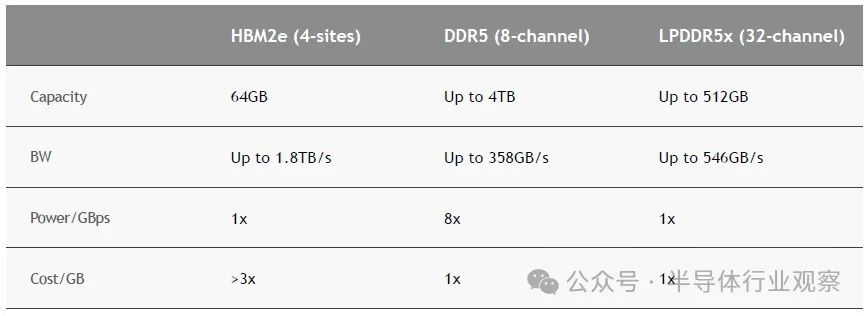

很难说这会花费多少钱。你不可能打电话给 Fry's Electronics 询问 2026 年 HBM4 内存的市场价格是多少。一方面,Fry's 已经死了。另一方面,我们现在甚至无法很好地了解 GPU 和其他矩阵引擎制造商为 HBM2e、HBM3 和 HBM3e 内存支付的费用。每个人都知道(或者认为他们知道),HBM 内存和用于将内存链接到设备的任何中介层是现代人工智能训练和推理引擎的两个主要成本。(当然,混合使用片上 SRAM 和普通 DRAM 的人除外。)

在市场上,用于服务器的最大、最厚、最快的 256 GB DDR5 内存模块在 4.8 GHz 下运行的价格约为 18,000 美元,每 GB 约为 70 美元。但仅可扩展至 32 GB 的更薄模块每 GB 成本仅为 35 美元。因此,HBM2e 的价格约为每 GB 110 美元,“超过 3 倍”,如上面的 Nvidia 图表所示。96 GB 的价格约为 10,600 美元。很难说 HBM3 和 HBM3E 的提升在该设备的“市场价格”上可能值多少钱,但如果达到 HBM3 仅提升 25%,那么 H100 的市场价格约为 30,000 美元80 GB 容量,HBM3 的价格为 8,800 美元。转向 96 GB HBM3E 可能会将内存成本提高到“市场价格”至 16,500 美元,因为技术成本又增加了 25%,而且额外的 16 GB 内存和 H100 96 GB 的市场价格应约为 37,700 美元。

听到有关具有 141 GB 容量(由于某种原因不是 144 GB)的 H200 的价格的传言将会很有趣。但如果这种内存价格分层成立——我们意识到这些都是疯狂的估计——那么 141 GB 的 HBM3E 本身价值约为 25,000 美元。但按照这样的价格,H200 的“市场价格”约为 41,000 美元。(注意:这不是我们认为 Nvidia 为 HBM3 和 HBM3E 内存支付的费用——这不是物料清单成本——而是分配给最终用户的价格。)

我们认为涨幅不会超过 25% 左右,因为内存升级到 HBM3,然后再升级到 HBM3E 将推高内存价格,使其高于市场上传闻的 Nvidia GPU 价格。

请记住,这只是一个思想实验,旨在展示 HBM 内存定价如何控制 Nvidia 和 AMD 可以投入该领域的 GPU 数量,而不是相反。内存尾巴正在摇晃 GPU 的狗。内存容量和带宽与 H200 的配合越来越紧密,如果 Nvidia 仅对额外的内存及其额外的速度收取象征性的费用,那么不仅设备的实际效率会提高,而且性价比也会提高。但如果 Nvidia 只是对这些更强大的 H100 和 H200 进行定价,以便性能增益和内存增益达到平衡,那么花的钱就会少得多,而要花的钱就会多得多。

老实说,我们不知道 Nvidia 会做什么,也不知道 AMD 在 MI300 获得 HBM3E 升级后会做什么。现在美光进入该领域的 HBM 供应商增加了 50%,而且 SK Hynix 和三星将产量提高了 2 倍,这是一个很大的数字,但相对于 GPU 和 GPU 的需求,市场上的 HBM 内存仍然只增加了 3 倍。他们的内存更大,可以说大于 3 倍。这不是一个可以降价的环境。在这种环境下,人们会提高更先进的计算引擎及其内存的价格,并继续尽可能薄地扩展 HBM 内存。

这就是为什么只要 Nvidia 平台继续成为首选,能够支付高价购买 HBM 内存的人(即 Nvidia 联合创始人兼首席执行官黄仁勋)就可以设定人工智能训练的步伐和价格。

换而言之,对于GPU和HBM来说,他们面对的都是生死局。

*博客内容为网友个人发布,仅代表博主个人观点,如有侵权请联系工作人员删除。